生活中心/綜合報導

臺灣AI人才技術大躍進,由臺灣大學電機工程學系郭斯彥特聘教授團隊與其學生陳韋廷博士,攜手知名社交媒體公司Snapchat合作,在人工智慧(AI)影像分割領域取得重大突破!他們在Meta提出的先進影像分割模型SAM(Segment Anything Model)的基礎上,開發出一種名為「RobustSAM」的創新模型,即使在處理品質較差的圖片時,也能進行高精度的影像分割。這項研究成果已被頂尖的計算機視覺與模式識別會議CVPR (Conference on Computer Vision and Pattern Recognition) 2024接受,並在11,532篇投稿中脫穎而出,被評選為焦點論文(Highlight Paper),接受率僅2.8%,即將在今年六月於美國西雅圖發表! 該研究的論文名稱為「RobustSAM: Segment Anything Robustly on Degraded Images」。

臺灣研究團隊郭斯彥教授目前為臺灣大學電機工程學系旺宏電子講座教授、美國電氣電子工程學會(IEEE)終生會士,陳韋廷為臺大電子所博士,過去曾任美國史丹佛大學博士研究、美國Meta Reality Lab和Snap Research的研究科學家實習生。此次與Snapchat合作提出的RobustSAM模型,而RobustSAM的創新之處是在於直接在SAM模型的基礎上加入了抗退化功能,使模型能夠直接對未經任何預處理的退化圖片進行高精度分割,從而簡化了整個處理流程,不再需要依賴外部的圖片處理步驟。

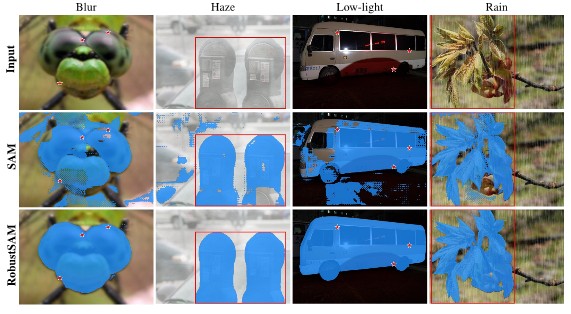

陳博士提出的RobustSAM(第三排結果),在影像分割的有效性及可靠性,優於現有的SAM架構下(第二排結果)。 圖/陳韋廷提供

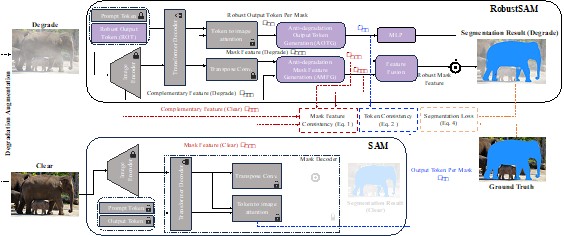

研究團隊通過引入兩個關鍵技術「抗退化輸出標記生成」和「抗退化遮罩特徵生成」,讓RobustSAM模型能夠從圖片中提取出與圖片退化無關的重要信息,且透過生成大量的清晰和退化圖片對,然後應用不同的算法來訓練模型,確保模型在處理清晰和退化圖片時,能夠保持一致性和準確性。

陳博士提出的RobustSAM的架構。圖/陳韋廷提供

影像分割技術在工業自動化、醫療影像分析、安全監控及自駕車等多個領域都有著廣泛應用。然而,現有的技術包括Meta的SAM影像分割模型在處理模糊、噪點、低光照(昏暗)等品質較差的圖片時,性能會明顯下降,讓人與機器無法精確辨識圖片。因此,透過RobustSAM全面升級圖片分割的質量,並增強了模型對圖片品質下降的抵抗力,讓影像分割模型得到更精準的結果。

陳博士表示,RobustSAM模型的開發離不開與Snapchat的合作,以及Meta的SAM模型所提供的基礎。Snapchat在計算機視覺和影像處理領域擁有豐富的專業知識和資源,為研究提供了寶貴的支持和指導。未來,陳博士將繼續與Snapchat保持合作,專注於計算機視覺領域的研究,致力於進一步提升AI技術在處理現實世界圖片方面的能力,讓這項技術能夠造福更多的行業和民眾。同時,他也期望RobustSAM能夠為其他研究者提供啟發,推動AI影像分割技術的發展。